界面新聞記者 |?彭新

英偉達在2023年全球超算大會(SC23)上推出了一款最新的AI芯片H200,用于AI大模型的訓練,相比于其前一代產品H100,H200的性能提升了約60%到90%。

H200是英偉達H100的升級版,與H100同樣基于Hopper架構,主要升級包括141GB的HBM3e顯存,顯存帶寬從H100的3.35TB/s增加到了4.8TB/s。

在大模型推理表現上,H200在700億參數的Llama2大模型上的推理速度比H100快了一倍,而且在推理能耗上H200相比H100直接降低了一半。對于顯存密集型HPC(高性能計算)應用,H200更高的顯存帶寬能夠確保高效地訪問數據,與CPU相比,獲得結果的時間最多可提升110倍。

由于架構相同,H200將與H100在軟件上相兼容,這意味著H200將具有H100的所有功能。英偉達宣稱,H200在大模型Llama 2、GPT-3.5的輸出速度上分別是H100的1.9倍和1.6倍。

英偉達加速計算總經理兼副總裁伊恩·巴克 (Ian Buck)稱:“想要通過生成式AI和HPC應用創造智能,就必須使用大型、快速的GPU顯存來高速、高效地處理海量數據(***)。借助H200,業界領先的端到端AI超級計算平臺的速度將會變得更快,一些世界上最重要的挑戰,都可以被解決。”

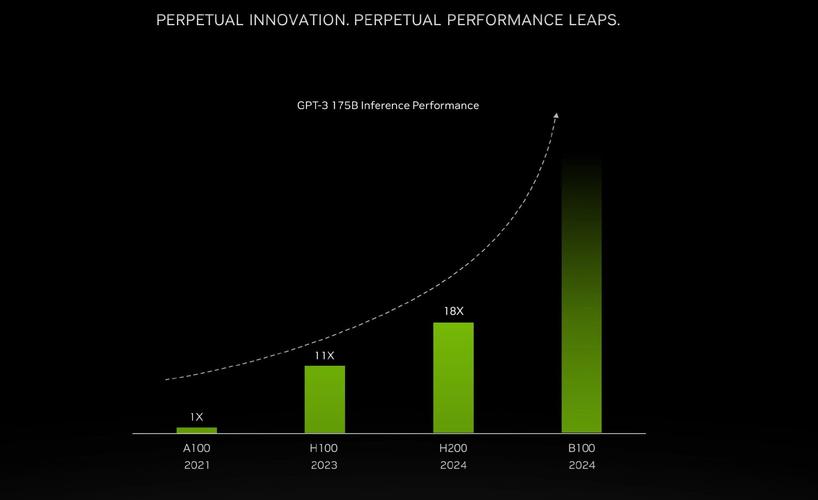

過去,英偉達數據中心AI芯片通常兩年更新一次芯片架構,最新芯片架構是Hopper。不過英偉達曾于上個月向投資人披露,由于市場對其AI芯片需求旺盛,公司將從每兩年發布一次新架構轉向每一年發布一次。 英偉達還向投資人稱,其將于2024年發布基于Blackwell架構的B100芯片。

H200將于2024年第二季度出貨。英偉達稱,從明年開始,亞馬遜云科技、谷歌云、微軟Azure 和甲骨文云將成為首批部署基于H200實例的云服務提供商。

英偉達股價在周一美股交易時段上漲,且已連續第九個交易日上漲,創出2016年12月27日以來的最長連漲走勢。今年以來,英偉達股價累計漲幅超過230%。